AIスタートアップのPKSHA Technology(東京都文京区、上野山 勝也代表取締役)は2024年3月、米マイクロソフト社の言語モデルアーキテクチャ「Retentive Network(RetNet)」を活用した大規模言語モデルを開発することを発表。4月以降にビジネス現場での実運用を開始する。

モデルのパラメータ数は70億。日英対応の言語モデルとして、PKSHA Technologyが独自に収集した日本語データを学習させる。マイクロソフト社のRetNet開発チームやDeepSpeedチームの協力を受けて開発する。同社によると、日本語の新聞紙2Pの情報量を入力した際に、精度を保ちながら従来モデルの約3.3倍の速度で出力が可能となるという。

PKSHA CommunicationおよびPKSHA Workplace 代表取締役社長の佐藤哲也氏

PKSHA Technologyは、2016年に前身のBEDOREでチャット型対話エンジン「BEDORE Conversation」を提供開始して以降、2023年3月に自社開発のLLM(大規模言語)「PKSHA LLMS」をリリースするなど、LLMの社会実装に向けて取り組んでいる。

PKSHA Technology アルゴリズムエンジニア VPoEの森下賢志氏

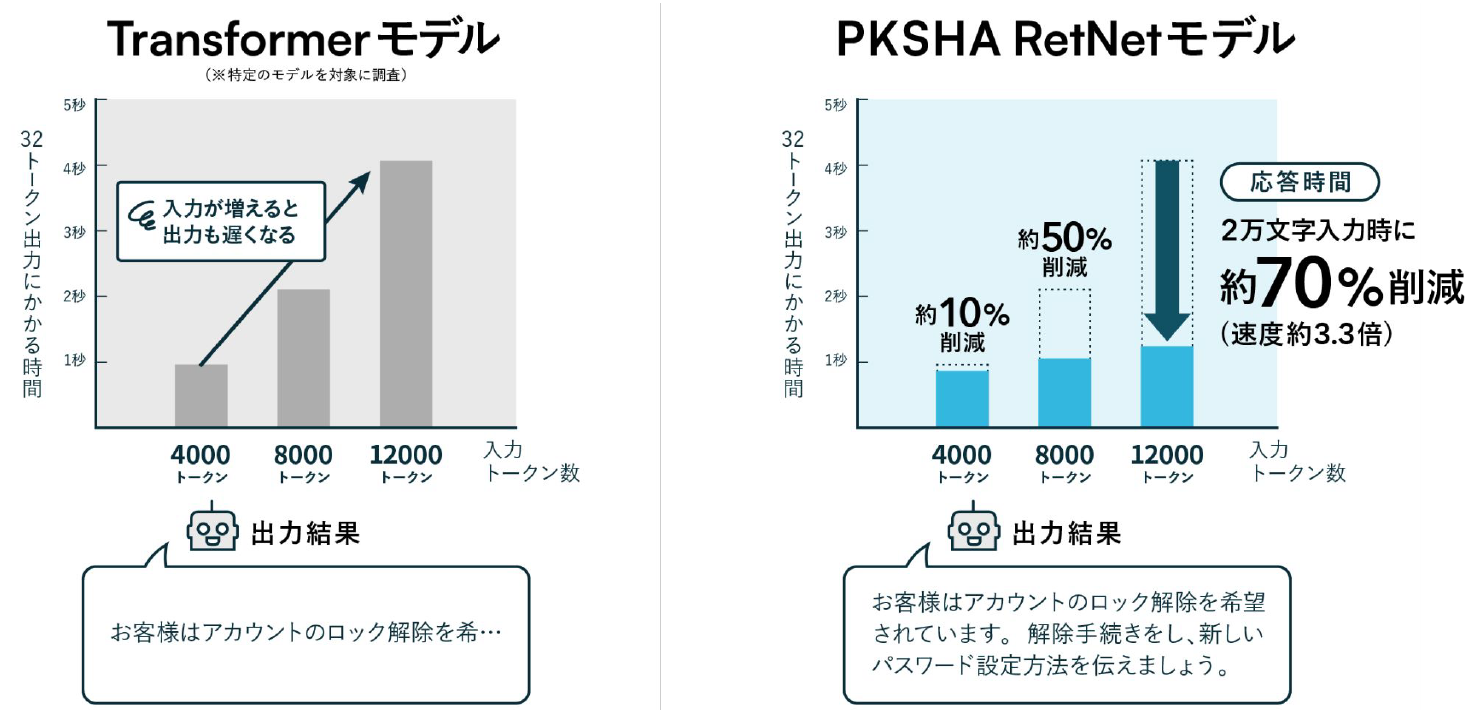

PKSHA Technology アルゴリズムエンジニア VPoEの森下賢志氏は、LLMの社会実装における課題として、「長文入力」「応答速度」「運用コスト」の3点の問題点を挙げ、「コンタクトセンターや社内ヘルプデスクでも、長文で入力するとかえって応答速度が遅くなり、また応答速度の向上のために高性能なサーバーを運用するとコストが上がるといった、トレードオフの関係にあります」と述べた。

図1 TransformerモデルとRetNetモデルの処理速度の違い

RetNetモデルを活用することで、従来型のTransformerモデルと比較して応答速度が向上するうえに、入力文字数(処理トークン数)を増やすほど、Transformerモデルよりも応答時間の削減効果が大きくなることが確認された。

図2 コンタクトセンターおよび社内ヘルプデスクの将来像

同社では、プロトタイプモデルの実用化を4月より段階的に開始することを公表。提供中のコンタクトセンター・社内ヘルプデスク向けのソリューションに関しても、年内を目処にRetNetモデルの実装を予定している。

PKSHA Technology アルゴリズムリードの稲原宗能氏

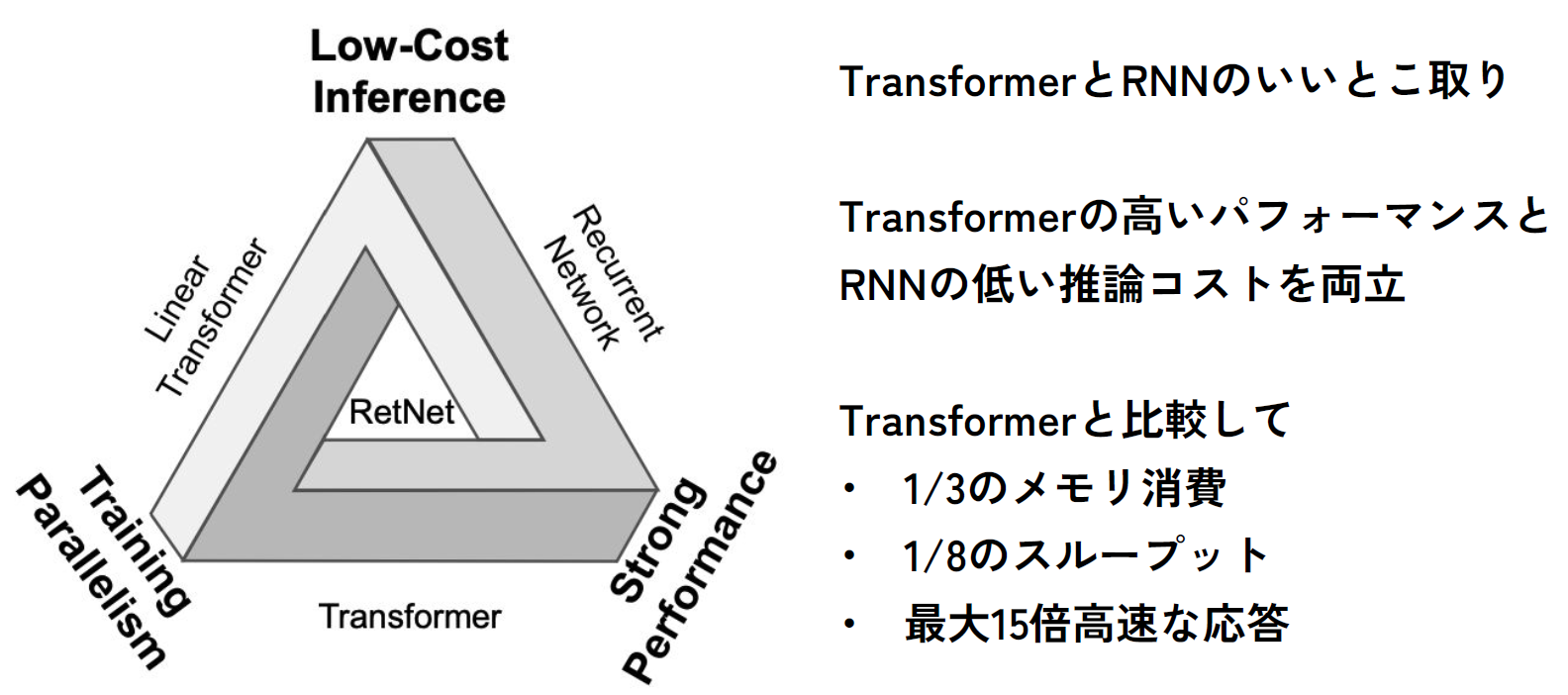

図3 言語モデルアーキテクチャ「Retentive Network(RetNet)」の特徴

PKSHA Technology アルゴリズムリードの稲原宗能氏は、RetNetの性能面について、「Transformerと比較して、メモリ消費を3分の1、スループット(データ転送速度)を8分の1まで削減でき、最大で15倍高速の応答を実現できる」と説明。「コールセンターの発話は従来のLLMが処理できない文字数になることが珍しくない。RetNetによって、一般的なサーバー上でも長文入力が可能となり、現実的な速度で全文を長文要約できるようになります」と解説した。メモリ消費量に関しても、Transformerはトークン数に応じて消費量が比例するのに対して、RetNetではトークン数が増加してもメモリ消費量は一定で、どれほど長い文章でもGPU1枚で処理できる。

日本マイクロソフト 執行役員の野嵜弘倫氏

日本マイクロソフト 執行役員の野嵜弘倫氏は、「RetNetは推論コストの削減や効率的なスケーリング、コスト効率の良いトレーニングといった側面で既存モデルよりも優れたパフォーマンスを発揮できる」と強調。同社は、PKSHA Technologyと提携、計算資源の提供やアーキテクチャ設計の支援を担う。

PKSHA Technology 代表取締役社長の上野山 勝也氏

PKSHA Technology 代表取締役社長の上野山 勝也氏は、「日本では2030年以降、人手不足がさらに深刻化することが予想されます。コンタクトセンターや社内ヘルプデスクにおいても必要十分でかつ高精度なプロダクトの開発が進み、今回発表のRetNetが有意義に機能できればと思います」と展望を述べた。

2024年04月01日 11時08分 公開

2024年04月01日 11時08分 更新