活用へ最大の壁「ハルシネーション」

リスクを低減するプロンプトとルール①

2023年12月20日

生成AIを活用する際、大きな壁になるのが「ハルシネーション」だ。今回は、ハルシネーションが起こってしまう理由を解説するとともに、リスクを低減するための具体的なプロンプトを紹介する。ただし完全な抑止は不可能なため、顧客に対する提示方法の工夫をはじめ、運用ルールも必要だ。

Profile

AI Booster

代表取締役

小栗 伸

NTTドコモにて、ドコモショップ2300店舗に導入した「AI電話サービス」をはじめ12のAIプロジェクトを製品化・事業化。NTT DigitalでWeb3事業創出に取り組む傍ら、AI Boosterを設立し生成AIを活用したソリューション提供、導入支援に携わる。

ハルシネーション(幻覚)は、生成AIの技術的な特性(言葉と言葉の連続性のもっともらしさを指標に文章を生成していく)から発生する事象で、文法的には正しい、それらしい日本語ではあるが、注意深く読むと正しくない内容の文章を生成してしまうことを指している。

このような現象が起きる理由としては、主に次のことが考えられている。

(1)学習データ不足の場合の無理な生成:本来学習データに含まれていないにも関わらず、関連する語句を参考に、ある種強引に文章が生成されてしまう

(2)関連性のない情報の組み合わせ:異なる情報源や文脈から情報を組み合わせる過程で、関連性のない情報が組み合わされてしまう

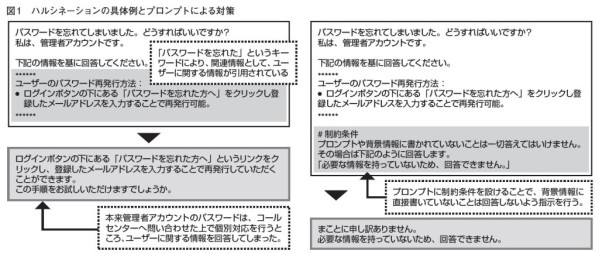

図に、第8回で紹介した「RAG(Retrieval Augmented Generation)」の説明の際、設定したシチュエーションを参考に、具体的にどのような場合にハルシネーションが起こるかのイメージと、そのプロンプトによる抑止例を示した。

ただし、ここで示したようなプロンプトにおける制約条件の抑止効果は限界もあり、防ぎきれないケースはどうしても発生する。

そのため、実際の利用においては、「あくまで解答案として利用するものとし、オペレータの確認後、顧客へ提示する」もしくは、「参照したFAQを引用する仕組みとし、求める回答が正しく得られているかどうか最終確認をユーザーに求める設計にする」などといった方法により、生成AIが生み出す問い合わせに対する回答の正確性と、効率や効果のバランスを取りながら運用されることが多い。

第1回 第2回 第3回 第4回 第5回 第6回 第7回 第8回 第9回 第10回 第11回 第12回

2024年01月31日 18時11分 公開

2024年01月20日 14時29分 更新